成果概括

随着大语言模型(LLMs)在智能助手、代码生成等领域的快速普及,如何在资源受限、隐私敏感的边缘侧高效部署与推理大模型,已成为工业界与学术界共同关注的核心问题 。天津大学 Edge Big Bang Group 聚焦边缘计算场景下算力异构与带宽受限的痛点,提出了自适应异构投机解码框架 EdgeSpec,并成功发表于计算机网络领域顶级国际会议 IEEE INFOCOM 2026。

IEEE INFOCOM (IEEE International Conference on Computer Communications) 是计算机网络领域顶级国际会议之一,中国计算机学会(CCF)推荐 A类 会议,在国际上享有极高的学术声誉。课题组博士生陈宇麟的论文《EdgeSpec: Distributed Speculative Decoding for Large Language Models at Edge》被 IEEE INFOCOM 2026 录用。

正文介绍

近年来,为缓解云端推理的高延迟与潜在隐私风险,研究者逐渐探索将大模型推理下沉至边缘侧 。然而,边缘环境普遍存在算力与内存差异显著的资源异构性,以及受限带宽导致的高通信开销等结构性约束。

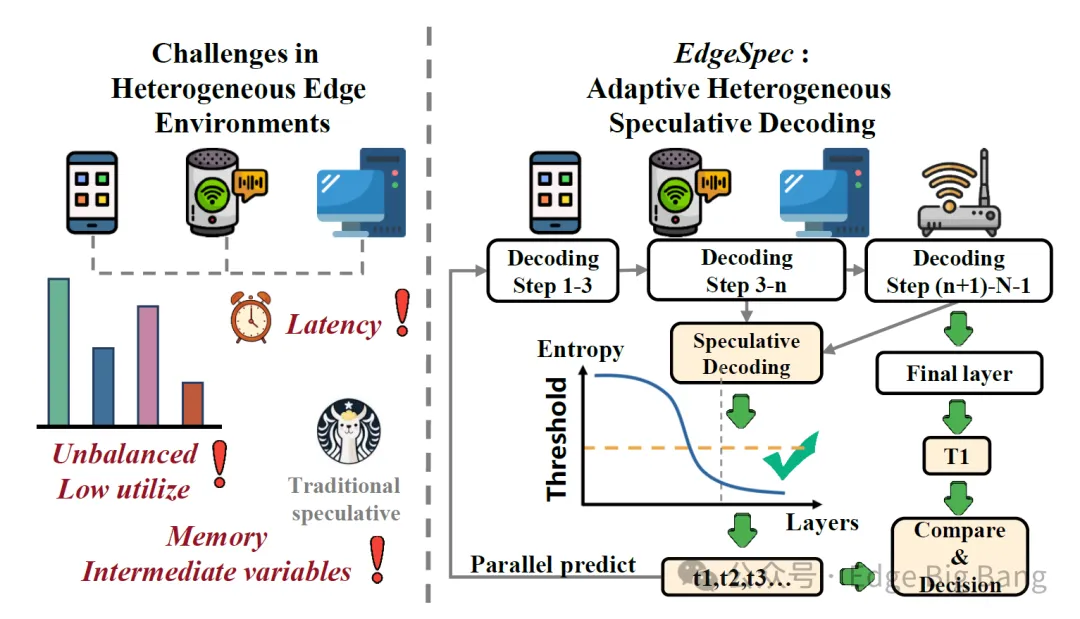

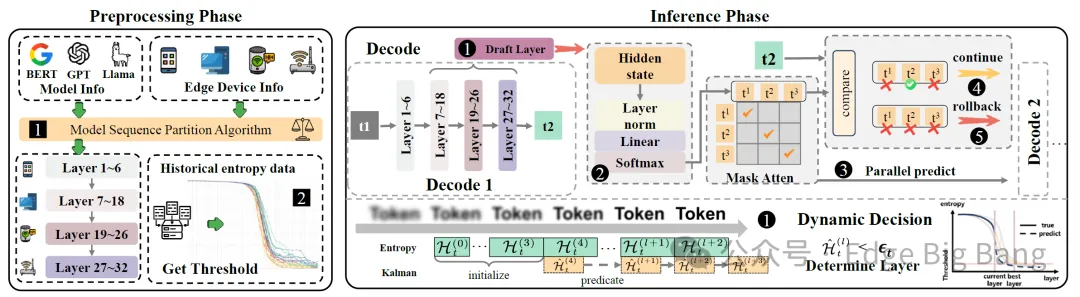

图1:异构边缘推理面临的挑战与 EdgeSpec 框架设计理念

我们在研究中发现,现有的分布式推理方法面临巨大挑战:

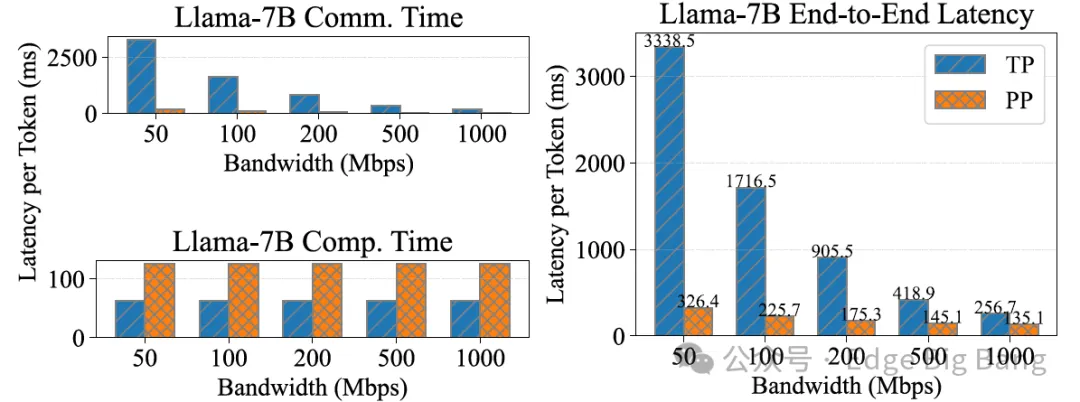

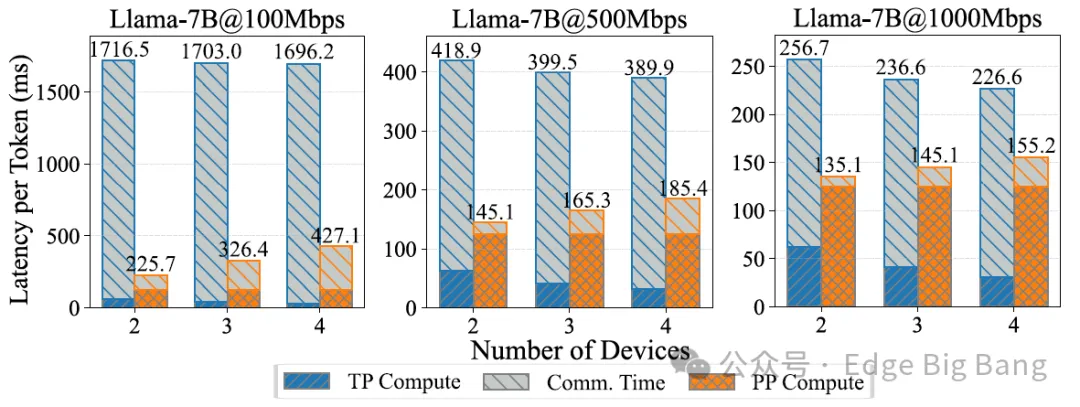

张量并行 (TP) 通信开销过大,在低带宽边缘网络下导致设备利用率极低;

流水线并行 (PP) 虽然减少了通信,但顺序执行导致了大量的“计算气泡”,设备空转严重;

现有的投机解码技术往往依赖额外的草稿模型(Draft Model),加剧了边缘设备的内存瓶颈 。

图2:现有并行策略(TP/PP)在有限带宽下的延迟瓶颈分析

核心挑战:

C1: 异构资源导致的负载不均衡边缘节点在计算能力和内存大小上参差不齐,静态的模型划分难以适应动态的负载,容易导致短板效应,增加端到端延迟。

C2: 投机解码在边缘的低效性。传统投机解码主要面向数据中心设计,假设高带宽互联和同构硬件。在边缘侧,引入额外的草稿模型会带来沉重的内存开销,且刚性的调度策略无法应对边缘网络的波动。

EdgeSpec 投机解码框架

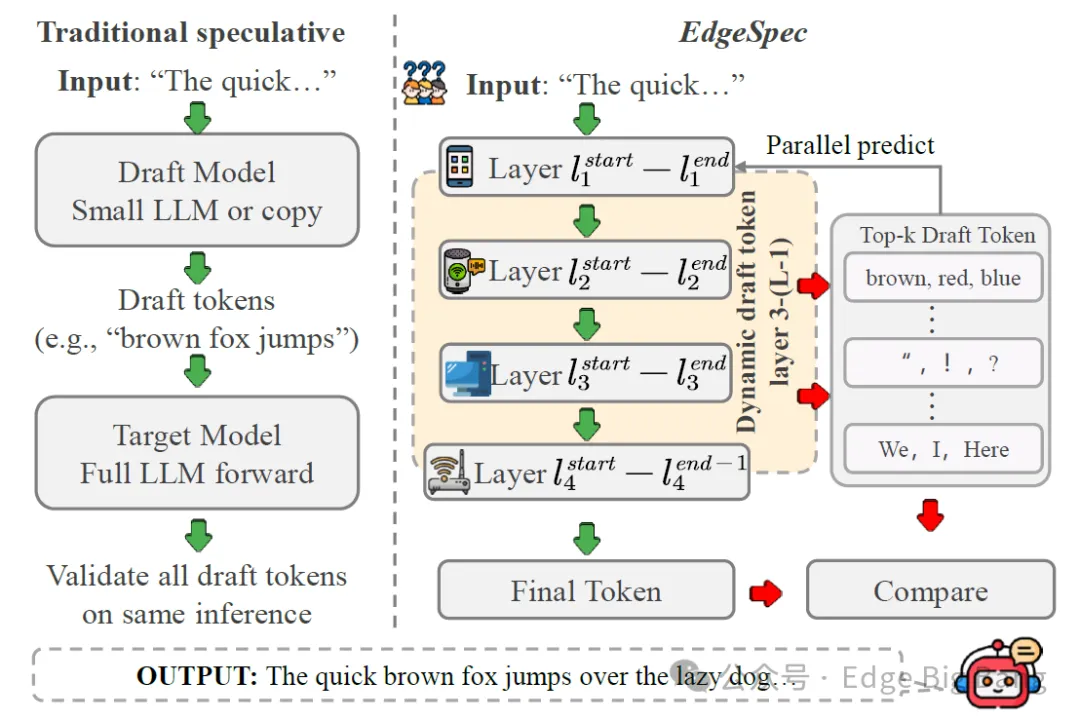

为应对上述挑战,我们提出了 EdgeSpec,一种专为异构边缘协作推理设计的分层投机解码框架 。EdgeSpec 摒弃了传统的独立草稿模型,创新性地利用大模型自身的中间层来生成草稿 token,并通过掩码注意力机制在不同设备间实现并行验证。

图3:EdgeSpec 与传统投机解码架构对比

本方法整体框架包含三个关键创新点:

层级化投机:不依赖额外模型,而是激活 Transformer 的中间层作为“起跳点”生成草稿。利用浅层网络计算快、深层网络精度高的特点,实现 token 的快速生成与并行验证。

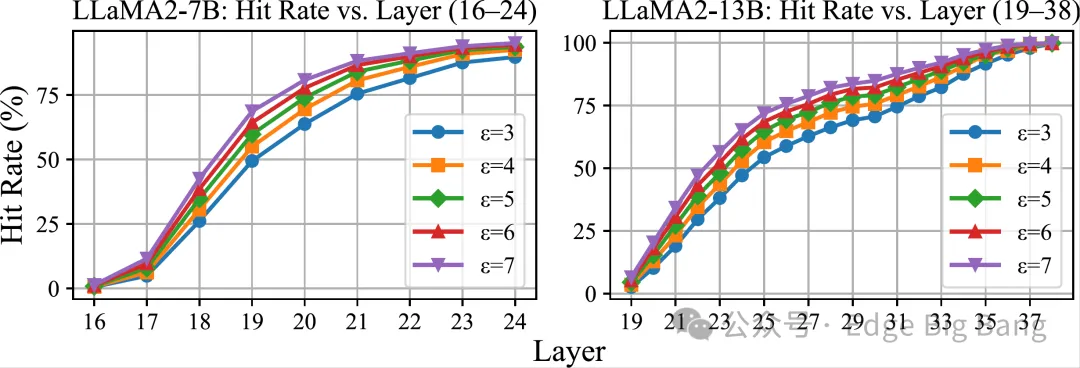

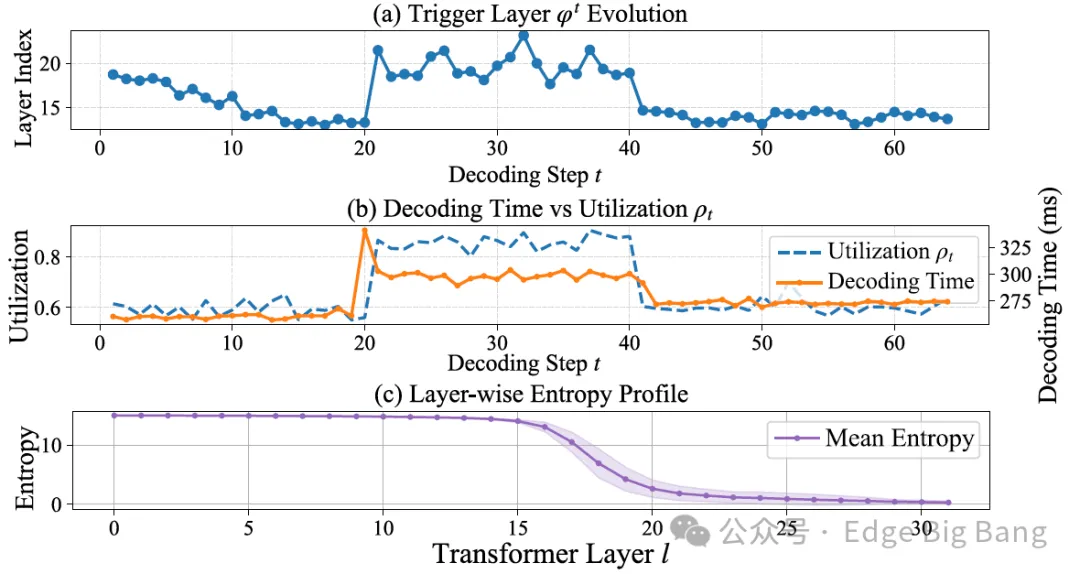

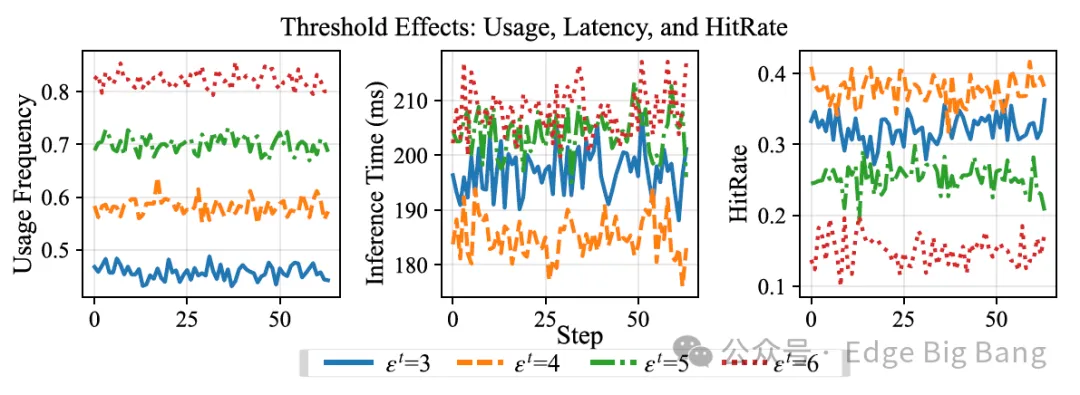

熵驱动的自适应调度:利用 卡尔曼滤波实时预测层级熵值,动态感知模型信心。结合运行时负载反馈,自适应调整投机触发阈值,在“激进加速”与“避免回滚”之间找到最佳平衡点。

存算协同的联合优化:设计了两阶段优化策略:离线阶段规划最优的模型切分与内存布局;在线阶段根据实时熵值动态选择触发层,无需迁移模型权重即可适应算力波动。

图4:EdgeSpec 系统工作流程概览

实验验证

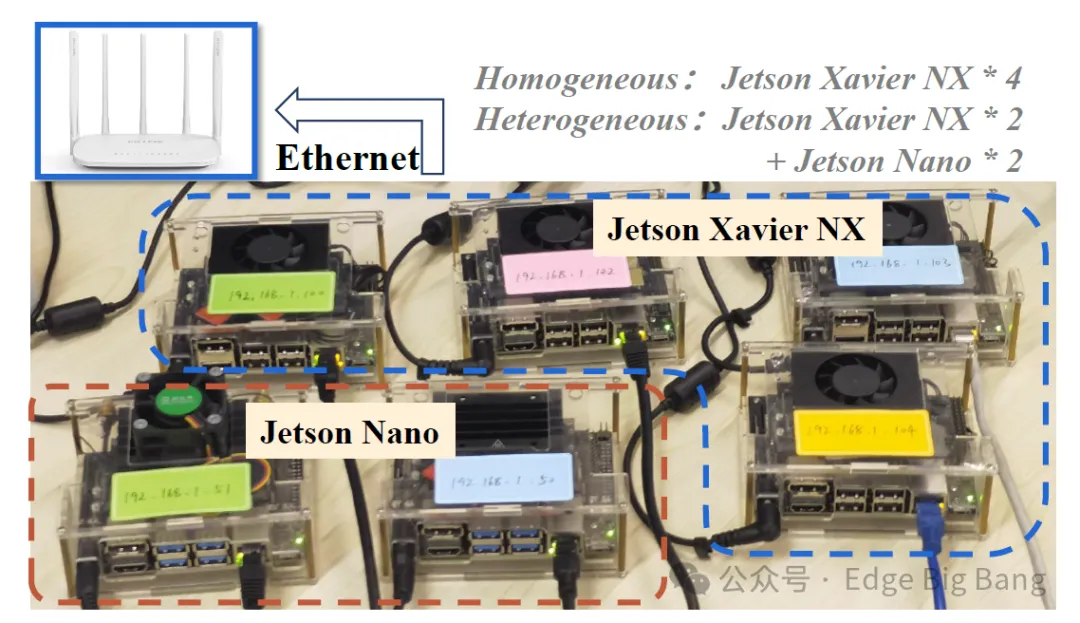

我们在包含 Jetson Xavier NX 和 Jetson Nano 的真实异构边缘集群上,使用 LLaMA2-7B 和 LLaMA2-13B 模型对 EdgeSpec 进行了系统评估。

图5:基于 Jetson 系列开发的边缘推理原型系统

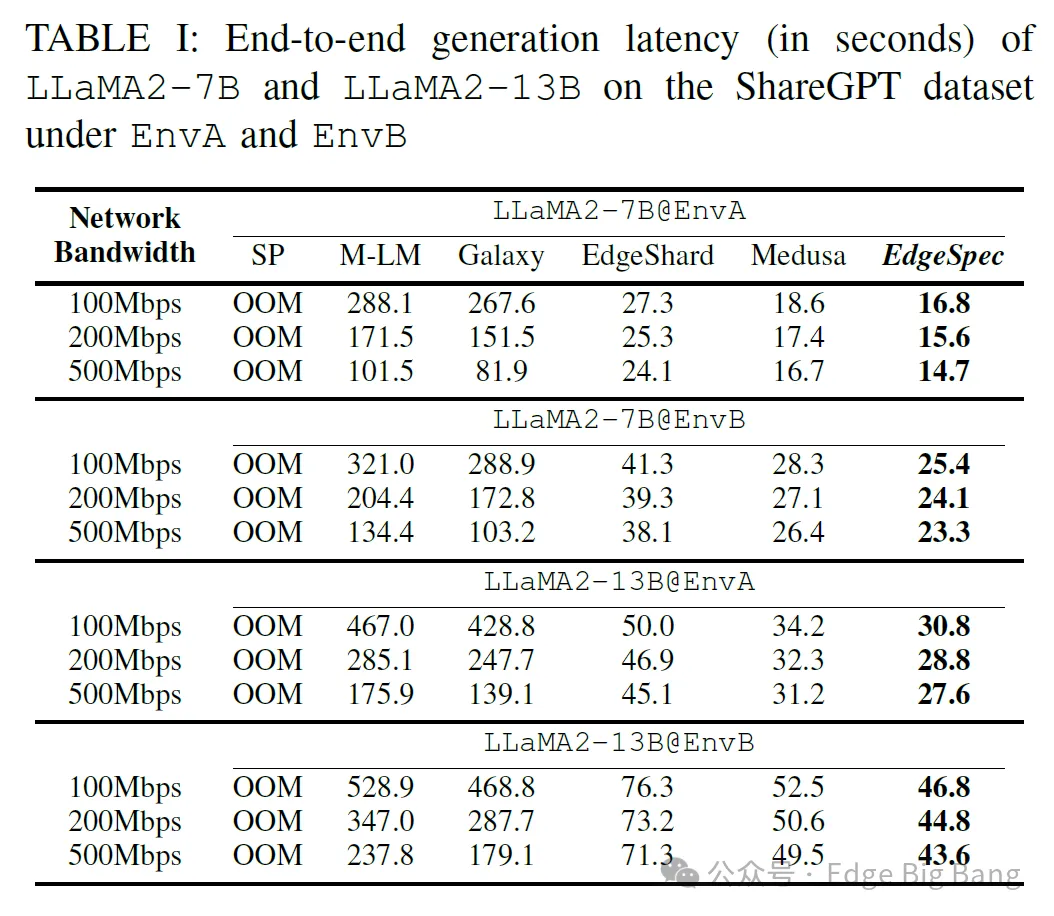

实验结果显示,与 SP、M-LM、Galaxy 以及适配边缘版的 Medusa 等基线方法相比:

极致加速: EdgeSpec 将推理延迟降低了 17.1倍 (LLAMA2-7B @100Mbps),显著优于传统并行方法。

超越 SOTA: 相比于同样采用投机解码的 Medusa,EdgeSpec 在边缘受限带宽下仍能保持更低延迟,且无需额外的模型训练开销。

无损精度: 通过严格的全模型验证机制,EdgeSpec 保证了输出内容与标准解码完全一致。

表1:不同带宽与设备环境下 EdgeSpec 与基线方法的延迟对比

图6:不同熵阈值下的投机命中率与系统性能权衡

Yulin Chen, Meng Tian, Chao Qiu, Xiaofei Wang, Haipeng Yao, Yuan He, Yunhao Liu, "EdgeSpec: Distributed Speculative Decoding for Large Language Models at Edge", in IEEE INFOCOM, 2026. (CCF-A类)

本篇论文的成功离不开课题组老师的专业指导与团队成员的共同努力。科研工作的价值在于立足实际问题、回应现实挑战,正是这些源自边缘智能落地一线的真实需求(如低延迟、隐私保护),让我们的研究更具方向感与生命力。

“寒梅傲雪,厚积薄发”,我们将持续聚焦边缘大模型系统优化中的关键问题,用学术的方法做出产业真正需要的解法。欢迎大家继续关注 Edge Big Bang Group,见证更多从现实中启发、向应用中落地的探索与突破!

阅读原文